Si tienes una página web, seguro que te has pasado por los logs de Apache o Nginx y has empezado a ver cómo han pasado por tu web multitud de Bad Bots para hacer scraping de tu contenido, pera análisis SEO, para comprobaciones de seguridad, spamming… De todo. Y, aunque no puedes bloquear todos sus intentos (hay cientos de bots recorriendo internet), sí que puede minimizar el impacto en tu web mediante la configuración de unas sencillas reglas en Cloudflare (o en tu archivo .htaccess del servidor).

¿Por qué prefiero hacerlo en Cloudflare? Primero, porque este dominio está gestionado mediante los DNS de Cloudflare. Segundo, porque es mejor bloquear estos bots gracias a la infraestructura de Cloudflare y en nuestro servidor: nos ahorramos recursos. Cloudflare proporciona protección a nivel de red, incluyendo mitigación de ataques DDoS y otras amenazas antes de que lleguen a tu servidor, y la gestión de sus reglas es muy sencilla. Te vas a tu panel de control y todo viene muy bien explicado. Además, te va a ofrecer estadísticas de los bloqueos.

Te puede interesar: Cómo bloquear bots, SPAM y tráfico malicioso con el firewall CSF y LFD o Cómo bloquear BOTS AI y SEO con Cloudflare y con el archivo .htaccess

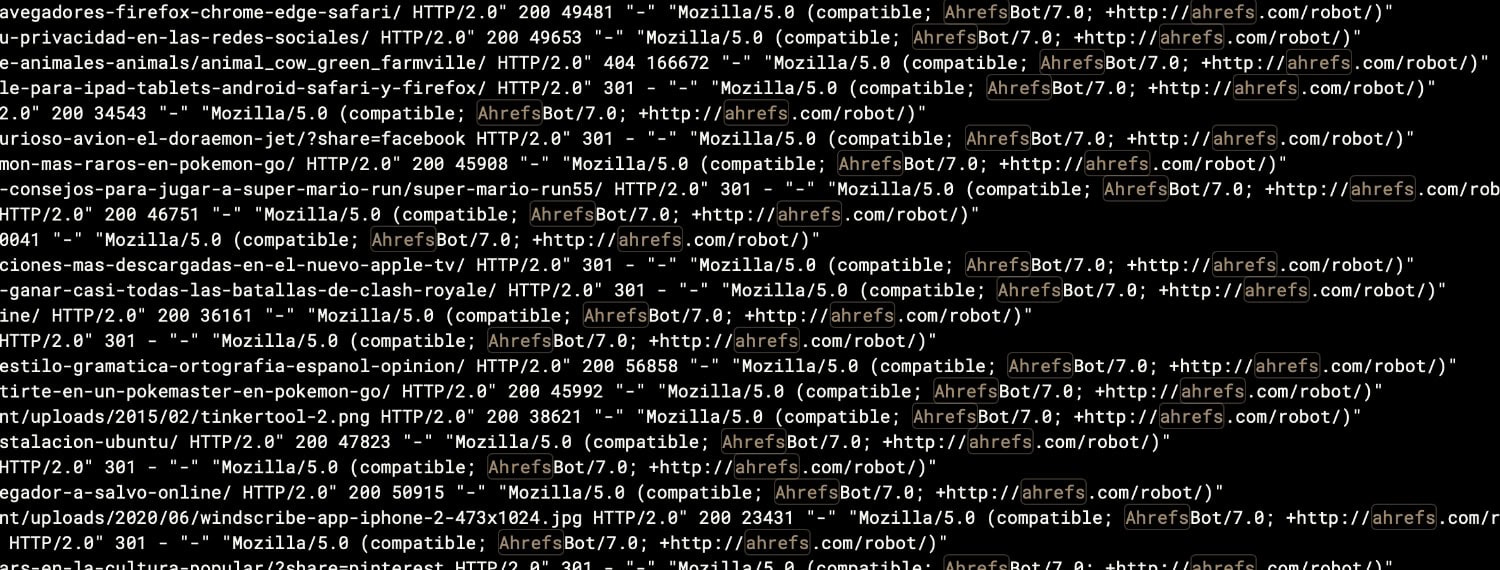

¿Quieres comprobar si estás afectado por el tráfico de estos Bots maliciosos? Solo tienes que ir a los logs de tu servidor. Si tienes Apache, normalmente las puedes encontrar en:

/var/log/apache2/access.log

/var/log/httpd/access.logDependiendo de tu sistema operativo Linux (Debian, Ubuntu o Red Hat, Rocky Linux, Alma Linux). Si usas PHP-FPM en tu servidor, estos logs se pueden haber trasladado a logs individuales:

/var/log/php-fpm/ejemplo_access.logEn esos logs, vas a encontrar todos los User Agents (Agentes de usuario) de todos los bots que visitan tu web.

¡Ojo! Lo que para mí puede ser un bot malicioso, a lo mejor para ti no lo es. Tienes que adaptar estas reglas a tu entorno. Un ejemplo. ¿Usas herramientas SEO como Ahrefs o SEMrush? Pues entonces debes quitar sus User Agents del listado. Luego te cuento más.

Vale. Mucha gente opta por incluir reglas de bloqueo directamente en .htaccess en su servidor, como por ejemplo las que ofrecen en Perishable Press y su 8G Firewall Addon. Esta configuración tiene muchas opciones, pero hay una específica para User Agents:

# 8G FIREWALL v1.3 20240222

# https://perishablepress.com/8g-firewall/

# 8G:[USER AGENT]

<IfModule mod_rewrite.c>

RewriteCond %{HTTP_USER_AGENT} ([a-z0-9]{2000,}) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (<|%0a|%0d|%27|%3c|%3e|%00|0x00|\\\x22) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (ahrefs|archiver|curl|libwww-perl|pycurl|scan) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (oppo\sa33|(c99|php|web)shell|site((.){0,2})copier) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (base64_decode|bin/bash|disconnect|eval|unserializ) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (acapbot|acoonbot|alexibot|asterias|attackbot|awario|backdor|becomebot|binlar|blackwidow|blekkobot|blex|blowfish|bullseye|bunnys|butterfly|careerbot|casper) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (checkpriv|cheesebot|cherrypick|chinaclaw|choppy|clshttp|cmsworld|copernic|copyrightcheck|cosmos|crescent|datacha|(\b)demon(\b)|diavol|discobot|dittospyder) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (dotbot|dotnetdotcom|dumbot|econtext|emailcollector|emailsiphon|emailwolf|eolasbot|eventures|extract|eyenetie|feedfinder|flaming|flashget|flicky|foobot|fuck) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (g00g1e|getright|gigabot|go-ahead-got|gozilla|grabnet|grafula|harvest|heritrix|httracks?|icarus6j|jetbot|jetcar|jikespider|kmccrew|leechftp|libweb|liebaofast) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (linkscan|linkwalker|loader|lwp-download|majestic|masscan|miner|mechanize|mj12bot|morfeus|moveoverbot|netmechanic|netspider|nicerspro|nikto|ninja|nominet|nutch) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (octopus|pagegrabber|petalbot|planetwork|postrank|proximic|purebot|queryn|queryseeker|radian6|radiation|realdownload|remoteview|rogerbot|scan|scooter|seekerspid) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (semalt|siclab|sindice|sistrix|sitebot|siteexplorer|sitesnagger|skygrid|smartdownload|snoopy|sosospider|spankbot|spbot|sqlmap|stackrambler|stripper|sucker|surftbot) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (sux0r|suzukacz|suzuran|takeout|teleport|telesoft|true_robots|turingos|turnit|vampire|vikspider|voideye|webleacher|webreaper|webstripper|webvac|webviewer|webwhacker) [NC,OR]

RewriteCond %{HTTP_USER_AGENT} (winhttp|wwwoffle|woxbot|xaldon|xxxyy|yamanalab|yioopbot|youda|zeus|zmeu|zune|zyborg) [NC]

RewriteRule .* - [F]

# RewriteRule .* /nG_log.php?log [END,NE,E=nG_USER_AGENT:%1]

</IfModule>Es una opción a considerar adaptando las reglas a tus necesidades. En mi caso, prefiero la opción de Cloudflare, pero los User Agents que han elegido en Perishable Press te pueden servir de guía para crear tu propia lista. Es un listado con relativamente pocos User Agents y es bastante manejable.

Si quieres listados más grandes, también los tienes, por ejemplo, el de https://github.com/mitchellkrogza/nginx-ultimate-bad-bot-blocker/blob/master/_generator_lists/bad-user-agents.list, con casi 700 User Agents. ¡Ojo! Nunca es recomendable ponerlos tal cual. Analiza tus necesidades. También puedes consultar: https://community.cloudflare.com/t/top-50-user-agents-to-block/222594.

¿Puedes hacer estos bloqueos en robots.txt? Puedes intentarlo, pero muchos de ellos se lo van a saltar a la torera. Este archivo debe estar ubicado en la raíz de tu servidor web (por ejemplo, https://www.tusitio.com/robots.txt) y tendrías que poner algo como esto:

User-agent: ahrefs

Disallow: /

User-agent: alexibot

Disallow: /

User-agent: aspiegelbot

Disallow: /- También te puede interesar: Cómo configurar las Cache Rules de Cloudflare para WordPress o Cache Everything en las nuevas Cache Rules de Cloudflare

Configuración en Cloudflare para bloquear Bots Maliciosos utilizando User Agents

¿De verdad tenemos que hacer todo esto si Cloudflare ya tiene un par de modos de luchar contra los bots: Bot Fight Mode y Super Bot Fight Mode? Pues sí, porque entre los «buenos bots» que tienen en su listado tenemos algunas opciones que no me gustan nada, cómo AhrefsBot, DataForSEO, ContentKing, Botify o Awario. ¡Ojo! Siempre puedes personalizar la regla del WAF con (cf.client.bot), que llama directamente a su listado. Puede ser útil en algunas ocasiones. El problema es que está lista no está publicada en su totalidad, así que no podemos saber si hay otros bots que no nos gusten.

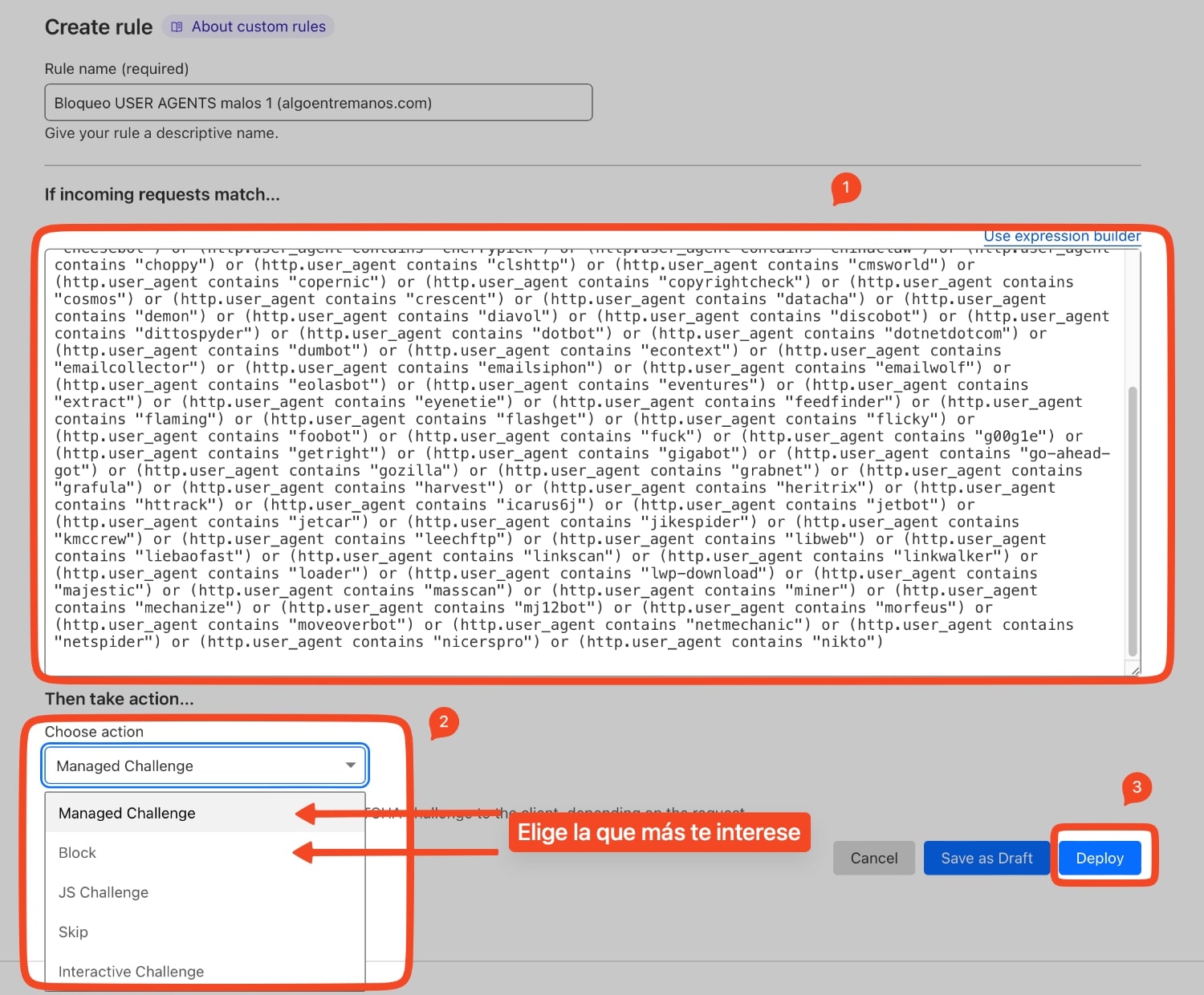

Lo primero que tienes que tener en cuenta, es que las reglas del WAF de Cloudflare solo pueden contener hasta 4000 caracteres, y que no admiten Regex en sus planes gratuitos (solo en los empresariales).

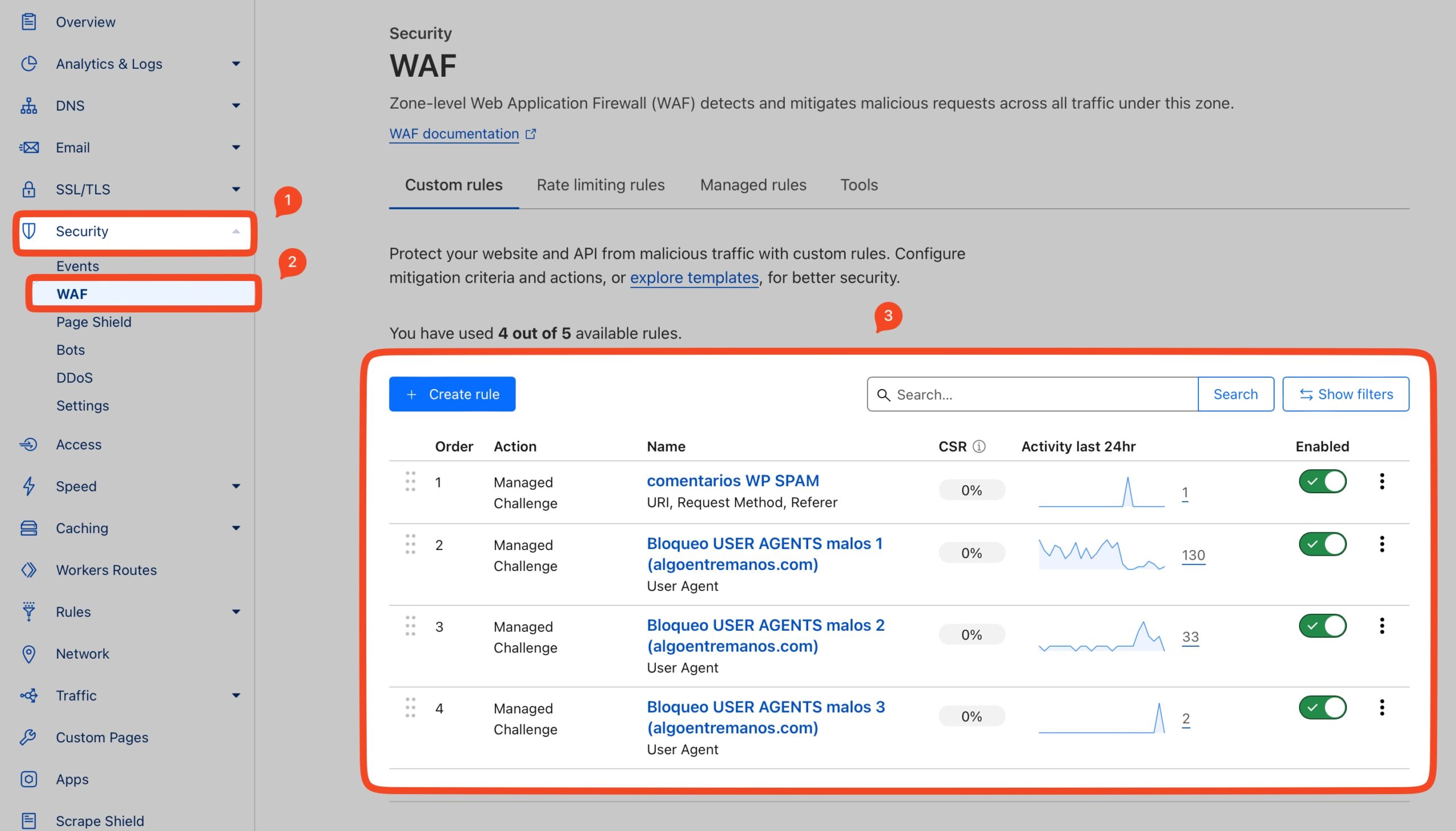

Vale. Lo primero que tenemos que hacer es ir al panel de Cloudflare, sección Security > WAF:

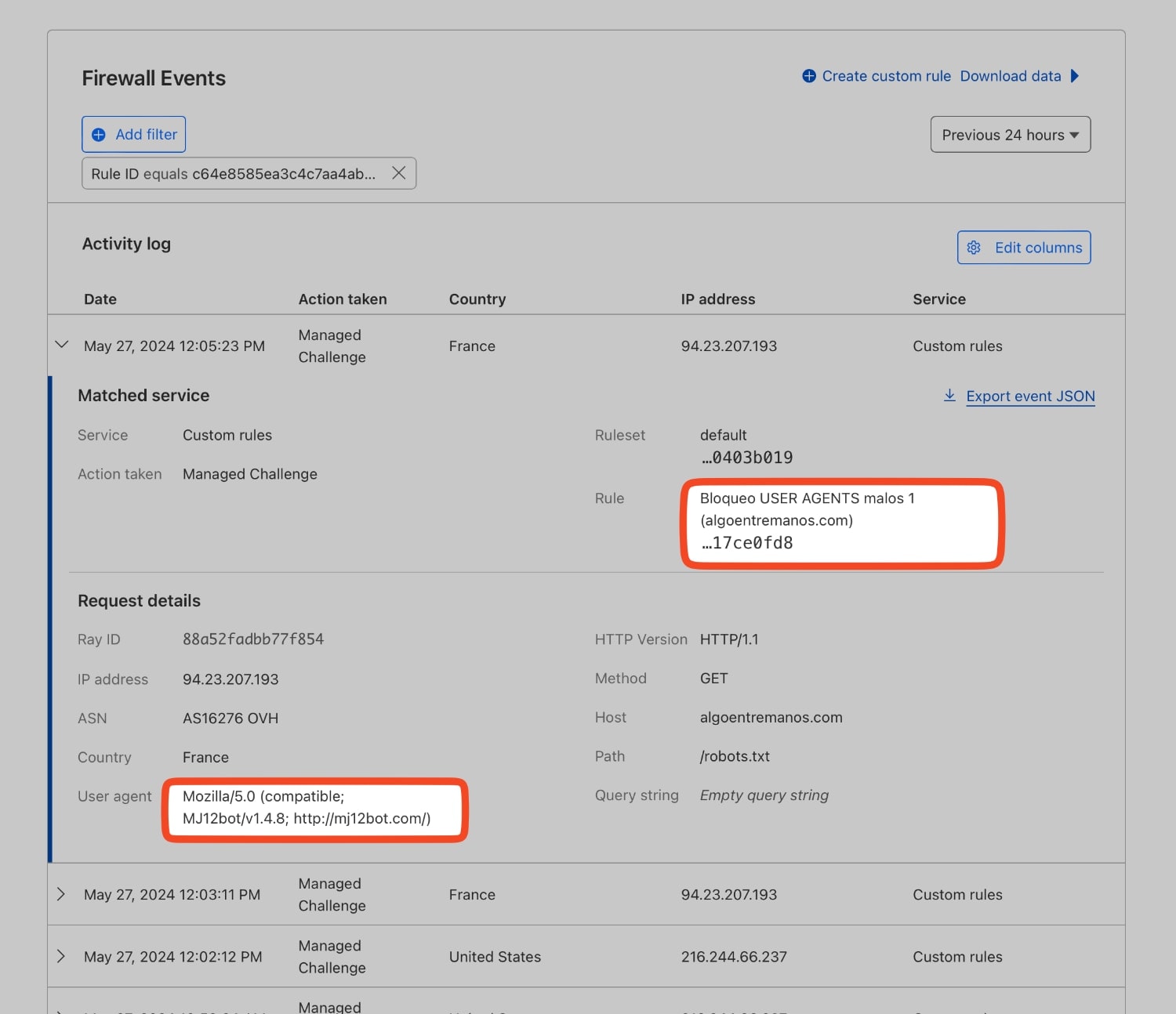

En mi caso, ya tengo configuradas tres reglas. Las dos primeras las tengo con User Agents que ya he comprobado que me afectan, y que no rompen nada de mi configuración. En la tercera regla, pruebo nuevos User Agents y veo de vez en cuando que están bloqueando. En las estadísticas ves los bloqueos de las últimas 24 horas. En mi caso no he puesto bloqueo, sino que se les presenta a estos bots un desafío Managed Challenge, que normalmente es suficiente para pararlos. Lo he dejado así por si hay algún falso positivo.

¿Qué tienes que hacer tú? Pincha en Create Rule y copia lo siguiente. Lo he dividido en tres reglas. Analízalas y decide si quieres usar los mismos User Agents que yo. Es decir, tienes que crear 3 reglas diferentes y pegar en cada una de ellas una de estas configuraciones de bloqueo (tienes que ponerlo en Edit Expression):

Regla 1

(http.user_agent contains "ahrefs") or (http.user_agent contains "acapbot") or (http.user_agent contains "acoonbot") or (http.user_agent contains "alexibot") or (http.user_agent contains "asterias") or (http.user_agent contains "attackbot") or (http.user_agent contains "awario") or (http.user_agent contains "backdor") or (http.user_agent contains "becomebot") or (http.user_agent contains "binlar") or (http.user_agent contains "blackwidow") or (http.user_agent contains "blekkobot") or (http.user_agent contains "blex") or (http.user_agent contains "blowfish") or (http.user_agent contains "bullseye") or (http.user_agent contains "bunnys") or (http.user_agent contains "butterfly") or (http.user_agent contains "careerbot") or (http.user_agent contains "casper") or (http.user_agent contains "whatcms") or (http.user_agent contains "trendictionbot") or (http.user_agent contains "linkfluence") or (http.user_agent contains "magpie-crawler") or (http.user_agent contains "mediatoolkitbot") or (http.user_agent contains "aspiegelbot") or (http.user_agent contains "domainstatsbot") or (http.user_agent contains "cincraw") or (http.user_agent contains "nimbostratus") or (http.user_agent contains "checkpriv") or (http.user_agent contains "cheesebot") or (http.user_agent contains "cherrypick") or (http.user_agent contains "chinaclaw") or (http.user_agent contains "choppy") or (http.user_agent contains "clshttp") or (http.user_agent contains "cmsworld") or (http.user_agent contains "copernic") or (http.user_agent contains "copyrightcheck") or (http.user_agent contains "cosmos") or (http.user_agent contains "crescent") or (http.user_agent contains "datacha") or (http.user_agent contains "demon") or (http.user_agent contains "diavol") or (http.user_agent contains "discobot") or (http.user_agent contains "dittospyder") or (http.user_agent contains "dotbot") or (http.user_agent contains "dotnetdotcom") or (http.user_agent contains "dumbot") or (http.user_agent contains "econtext") or (http.user_agent contains "emailcollector") or (http.user_agent contains "emailsiphon") or (http.user_agent contains "emailwolf") or (http.user_agent contains "eolasbot") or (http.user_agent contains "eventures") or (http.user_agent contains "extract") or (http.user_agent contains "eyenetie") or (http.user_agent contains "feedfinder") or (http.user_agent contains "flaming") or (http.user_agent contains "flashget") or (http.user_agent contains "flicky") or (http.user_agent contains "foobot") or (http.user_agent contains "fuck") or (http.user_agent contains "g00g1e") or (http.user_agent contains "getright") or (http.user_agent contains "gigabot") or (http.user_agent contains "go-ahead-got") or (http.user_agent contains "gozilla") or (http.user_agent contains "grabnet") or (http.user_agent contains "grafula") or (http.user_agent contains "harvest") or (http.user_agent contains "heritrix") or (http.user_agent contains "httrack") or (http.user_agent contains "icarus6j") or (http.user_agent contains "jetbot") or (http.user_agent contains "jetcar") or (http.user_agent contains "jikespider") or (http.user_agent contains "kmccrew") or (http.user_agent contains "leechftp") or (http.user_agent contains "libweb") or (http.user_agent contains "liebaofast") or (http.user_agent contains "linkscan") or (http.user_agent contains "linkwalker") or (http.user_agent contains "loader") or (http.user_agent contains "lwp-download") or (http.user_agent contains "majestic") or (http.user_agent contains "masscan") or (http.user_agent contains "miner") or (http.user_agent contains "mechanize") or (http.user_agent contains "mj12bot") or (http.user_agent contains "morfeus") or (http.user_agent contains "moveoverbot") or (http.user_agent contains "netmechanic") or (http.user_agent contains "netspider") or (http.user_agent contains "nicerspro") or (http.user_agent contains "nikto")- Acción a elegir: Te recomiendo Managed Challenge o Block.

- Le das a Deploy para que se ponga en marcha.

Regla 2

(http.user_agent contains "ninja") or (http.user_agent contains "nominet") or (http.user_agent contains "nutch") or (http.user_agent contains "octopus") or (http.user_agent contains "pagegrabber") or (http.user_agent contains "petalbot") or (http.user_agent contains "planetwork") or (http.user_agent contains "postrank") or (http.user_agent contains "proximic") or (http.user_agent contains "purebot") or (http.user_agent contains "queryn") or (http.user_agent contains "queryseeker") or (http.user_agent contains "radian6") or (http.user_agent contains "radiation") or (http.user_agent contains "realdownload") or (http.user_agent contains "remoteview") or (http.user_agent contains "rogerbot") or (http.user_agent contains "scooter") or (http.user_agent contains "seekerspid") or (http.user_agent contains "serpstatbot") or (http.user_agent contains "semrush") or (http.user_agent contains "semalt") or (http.user_agent contains "siclab") or (http.user_agent contains "sindice") or (http.user_agent contains "sistrix") or (http.user_agent contains "sitebot") or (http.user_agent contains "siteexplorer") or (http.user_agent contains "sitesnagger") or (http.user_agent contains "skygrid") or (http.user_agent contains "smartdownload") or (http.user_agent contains "snoopy") or (http.user_agent contains "sosospider") or (http.user_agent contains "spankbot") or (http.user_agent contains "spbot") or (http.user_agent contains "sqlmap") or (http.user_agent contains "stackrambler") or (http.user_agent contains "stripper") or (http.user_agent contains "sucker") or (http.user_agent contains "surftbot") or (http.user_agent contains "sux0r") or (http.user_agent contains "suzukacz") or (http.user_agent contains "suzuran") or (http.user_agent contains "takeout") or (http.user_agent contains "teleport") or (http.user_agent contains "telesoft") or (http.user_agent contains "true_robots") or (http.user_agent contains "turingos") or (http.user_agent contains "turnit") or (http.user_agent contains "vampire") or (http.user_agent contains "vikspider") or (http.user_agent contains "voideye") or (http.user_agent contains "webleacher") or (http.user_agent contains "webreaper") or (http.user_agent contains "webstripper") or (http.user_agent contains "webvac") or (http.user_agent contains "webviewer") or (http.user_agent contains "webwhacker") or (http.user_agent contains "winhttp") or (http.user_agent contains "wwwoffle") or (http.user_agent contains "woxbot") or (http.user_agent contains "xaldon") or (http.user_agent contains "xxxyy") or (http.user_agent contains "yamanalab") or (http.user_agent contains "yioopbot") or (http.user_agent contains "youda") or (http.user_agent contains "zeus") or (http.user_agent contains "zmeu") or (http.user_agent contains "zune") or (http.user_agent contains "zyborg")- Acción a elegir: Te recomiendo Managed Challenge o Block.

- Le das a Deploy para que se ponga en marcha.

Regla 3

(http.user_agent contains "internet-structure-research-project-bot") or (http.user_agent contains "sqlmap") or (http.user_agent contains "nessus") or (http.user_agent contains "masscan") or (http.user_agent contains "megaindex") or (http.user_agent contains "scrapy") or (http.user_agent contains "voluumdsp") or (http.user_agent contains "barkrowler") or (http.user_agent contains "semanticbot") or (http.user_agent contains "cocolyzebot") or (http.user_agent contains "domcopbot") or (http.user_agent contains "riddler") or (http.user_agent contains "pubmatic") or (http.user_agent contains "moatbot") or (http.user_agent contains "ltx71") or (http.user_agent contains "bomborabot") or (http.user_agent contains "seekport") or (http.user_agent contains "gulperbot") or (http.user_agent contains "rasabot") or (http.user_agent contains "zoominfobot") or (http.user_agent contains "coccocbot") or (http.user_agent contains "tineye") or (http.user_agent contains "webtechbot") or (http.user_agent contains "clickagy") or (http.user_agent contains "sbl-bot") or (http.user_agent contains "semantic-visions") or (http.user_agent contains "expanseinc") or (http.user_agent contains "screaming") or (http.user_agent contains "okhttp") or (http.user_agent contains "dataforseo") or (http.user_agent contains "contentking") or (http.user_agent contains "siteauditbot") or (http.user_agent contains "botify")- Acción a elegir: Te recomiendo Managed Challenge o Block.

- Le das a Deploy para que se ponga en marcha.

¿Qué estás poniendo en estas reglas de bloqueo? Un ejemplo:

- http.user_agent: Es el encabezado HTTP que indica el agente de usuario, que describe el navegador web, bot o cualquier otra herramienta que realiza la solicitud. Este encabezado incluye información sobre el software y, a veces, sobre el sistema operativo del cliente.

- contains «ahrefs»: Esta parte de la expresión verifica si el agente de usuario contiene la cadena «ahrefs».

- AhrefsBot: Es un bot utilizado por Ahrefs, una herramienta de análisis SEO que rastrea sitios web para recopilar datos sobre enlaces, contenido y otras métricas SEO. Aunque es legítimo, puede consumir muchos recursos del servidor debido a su naturaleza intensiva de rastreo.

- or: Operador lógico que indica que si cualquiera de las condiciones evaluadas es verdadera, la expresión completa se considera verdadera.

Todo esto es mucho más sencillo de implementar en Cloudflare que en tú .htaccess. En cuanto le des a Deploy, el Firewall de Cloudflare se pondrá como un loco a bloquear estos bots. Si pinchas en las estadísticas, lo puedes comprobar:

- Te puede interesar: Cómo desactivar rendimiento de Cloudflare en wp-admin (WordPress) o Configuración de mod_remoteip con Apache y Cloudflare.

Listado de User Agents de Bots que he elegido

¿Tienes que poner todos Agentes de Usuarios de todos estos bots? Tienes que valorarlo tú mismo. Aquí te dejo una tabla explicándote que hace cada uno de los que elegido yo, e indicándote de 0 a 10 (siendo 10 la puntuación más alta) si merece la pena bloquearlos o no (con una puntuación de 7 a 10 los bloquearía).

| Nº | User Agent | Descripción | Clasificación de Bloqueo |

|---|---|---|---|

| 1 | acapbot | Utilizado para análisis y scraping de contenido. | 7 |

| 2 | acoonbot | Utilizado para indexar contenido, puede ser intensivo en recursos. | 7 |

| 3 | ahrefs | Utilizado por Ahrefs para análisis SEO y backlinks. | 6 |

| 4 | alexibot | Realiza scraping masivo de contenido, a menudo con fines maliciosos. | 10 |

| 5 | aspiegelbot | Utilizado por Huawei para indexación y análisis de contenido web. | 6 |

| 6 | asterias | Realiza scraping web, potencialmente agresivo en términos de solicitudes. | 8 |

| 7 | attackbot | Utilizado para ataques y scraping agresivo. | 10 |

| 8 | awario | Utilizado para monitoreo de redes sociales y análisis de contenido. | 5 |

| 9 | backdor | Busca vulnerabilidades en sitios web. | 10 |

| 10 | barkrowler | Realiza scraping intensivo que puede afectar el rendimiento del servidor. | 9 |

| 11 | becomebot | Utilizado para indexar contenido, generalmente no muy intensivo. | 4 |

| 12 | binlar | Conocido por su actividad agresiva y no deseada. | 9 |

| 13 | blackwidow | Herramienta de scraping y prueba de penetración, puede ser maliciosa. | 10 |

| 14 | blekkobot | Utilizado por Blekko, un motor de búsqueda. | 5 |

| 15 | blex | Realiza scraping y análisis de contenido. | 7 |

| 16 | blowfish | Conocido por scraping y actividades de hacking. | 10 |

| 17 | bomborabot | Realiza análisis y recopilación de datos para marketing. | 5 |

| 18 | botify | Utilizado para análisis SEO y auditoría de sitios web. | 5 |

| 19 | bullseye | Realiza scraping intensivo utilizado para recopilar datos. | 9 |

| 20 | bunnys | Utilizado para scraping de contenido, potencialmente intensivo. | 7 |

| 21 | butterfly | Realiza rastreo web y scraping, puede ser intensivo en recursos. | 7 |

| 22 | careerbot | Utilizado para buscar ofertas de empleo y contenido relacionado. | 3 |

| 23 | casper | Utilizado en herramientas de automatización web para scraping. | 8 |

| 24 | checkpriv | Realiza pruebas de seguridad, puede buscar vulnerabilidades. | 9 |

| 25 | cheesebot | Utilizado para recopilar datos de sitios web. | 7 |

| 26 | cherrypick | Utilizado para scraping y posibles ataques. | 10 |

| 27 | chinaclaw | Realiza scraping intensivo, a menudo bloqueado por su agresividad. | 8 |

| 28 | choppy | Realiza scraping web, potencialmente malicioso. | 8 |

| 29 | cincraw | Utilizado para indexar contenido. | 5 |

| 30 | clickagy | Utilizado para publicidad y análisis, puede ser intensivo en recursos. | 6 |

| 31 | clshttp | Utilizado para pruebas de rendimiento y carga. | 7 |

| 32 | cmsworld | Realiza análisis y scraping de contenido web. | 7 |

| 33 | coccocbot | Bot de un motor de búsqueda vietnamita, similar a Googlebot. | 4 |

| 34 | cocolyzebot | Realiza análisis y scraping web, utilizado para SEO. | 6 |

| 35 | copernic | Utilizado para indexar contenido web, puede ser intensivo. | 6 |

| 36 | copyrightcheck | Utilizado para verificar infracciones de derechos de autor. | 4 |

| 37 | cosmos | Realiza scraping web y análisis de contenido. | 7 |

| 38 | crescent | Realiza scraping, puede ser malicioso o intensivo. | 8 |

| 39 | datacha | Realiza scraping y análisis de contenido web. | 7 |

| 40 | dataforseo | Utilizado para análisis SEO y recopilación de datos. | 5 |

| 41 | demon | Conocido por scraping y actividades de hacking. | 10 |

| 42 | diavol | Similar a demon, realiza actividades de hacking y scraping. | 10 |

| 43 | discobot | Utilizado en plataformas de discusión y foros para scraping. | 6 |

| 44 | dittospyder | Realiza scraping y análisis de contenido. | 7 |

| 45 | domainstatsbot | Utilizado para recopilar estadísticas de dominios. | 5 |

| 46 | domcopbot | Realiza análisis SEO y rastreo web. | 5 |

| 47 | dotbot | Realiza scraping y análisis de contenido web. | 6 |

| 48 | dotnetdotcom | Realiza análisis y scraping web. | 6 |

| 49 | dumbot | Conocido por scraping agresivo. | 9 |

| 50 | econtext | Realiza análisis de contenido y scraping. | 6 |

| Nº | User Agent | Descripción | Clasificación de Bloqueo |

|---|---|---|---|

| 51 | emailcollector | Recolecta direcciones de correo electrónico, generalmente con fines maliciosos. | 10 |

| 52 | emailsiphon | Similar a emailcollector, utilizado para recolectar correos electrónicos. | 10 |

| 53 | emailwolf | Recolecta correos electrónicos, generalmente con fines de spam. | 10 |

| 54 | eolasbot | Realiza scraping y análisis web. | 6 |

| 55 | eventures | Realiza scraping y análisis de contenido. | 6 |

| 56 | expanseinc | Realiza análisis de seguridad y scraping. | 7 |

| 57 | extract | Realiza scraping web, potencialmente malicioso. | 8 |

| 58 | eyenetie | Realiza scraping y análisis de contenido. | 7 |

| 59 | feedfinder | Encuentra y analiza feeds RSS. | 5 |

| 60 | flaming | Realiza scraping y posibles ataques. | 10 |

| 61 | flashget | Gestor de descargas que puede generar múltiples solicitudes. | 6 |

| 62 | flicky | Realiza scraping y análisis de contenido. | 7 |

| 63 | foobot | Realiza scraping web, potencialmente intensivo en recursos. | 7 |

| 64 | fuck | Realiza actividades de scraping agresivo. | 10 |

| 65 | getright | Gestor de descargas, puede generar múltiples solicitudes y consumir recursos. | 6 |

| 66 | gigabot | Utilizado por Gigablast, un motor de búsqueda. | 5 |

| 67 | go-ahead-got | Realiza scraping web, puede ser intensivo en recursos. | 7 |

| 68 | gozilla | Gestor de descargas, similar a flashget. | 6 |

| 69 | grabnet | Realiza scraping web para recopilar datos. | 7 |

| 70 | grafula | Conocido por su agresividad en scraping. | 9 |

| 71 | gulperbot | Realiza scraping y análisis de contenido web. | 7 |

| 72 | harvest | Realiza scraping web, puede ser intensivo en recursos. | 8 |

| 73 | heritrix | Utilizado por Internet Archive para archivar web. | 4 |

| 74 | httrack | Herramienta de clonación de sitios web, puede generar muchas solicitudes. | 8 |

| 75 | icarus6j | Realiza scraping, potencialmente malicioso. | 9 |

| 76 | internet-structure-research-project-bot | Realiza análisis de estructura de internet, no respeta robots.txt y puede ser muy intensivo. | 10 |

| 77 | jetbot | Realiza scraping y análisis de contenido web. | 7 |

| 78 | jetcar | Gestor de descargas, similar a gozilla y flashget. | 6 |

| 79 | jikespider | Realiza scraping web, puede ser intensivo en recursos. | 7 |

| 80 | kmccrew | Realiza scraping y análisis de contenido web. | 7 |

| 81 | leechftp | Herramienta de descarga FTP, puede generar múltiples solicitudes. | 6 |

| 82 | libweb | Biblioteca de HTTP, a menudo utilizada en scripts de scraping. | 6 |

| 83 | liebaofast | Realiza scraping web, potencialmente intensivo. | 7 |

| 84 | linkfluence | Realiza análisis de enlaces y contenido web. | 5 |

| 85 | linkpadbot | Utilizado en SEO para análisis de enlaces. | 5 |

| 86 | linkscan | Realiza análisis de enlaces y contenido web. | 5 |

| 87 | linkwalker | Realiza análisis de enlaces y contenido web. | 5 |

| 88 | loader | Realiza scraping web, puede ser intensivo en recursos. | 7 |

| 89 | ltx71 | Realiza scraping y análisis de contenido web. | 7 |

| 90 | lwp-download | Biblioteca utilizada en scripts de descarga y scraping. | 6 |

| 91 | magpie-crawler | Realiza scraping y análisis de contenido web. | 7 |

| 92 | majestic | Realiza análisis SEO y rastreo web. | 5 |

| 93 | masscan | Herramienta de escaneo de puertos, potencialmente peligrosa. | 10 |

| 94 | mechanize | Biblioteca de automatización web, utilizada en scraping. | 7 |

| 95 | mediatoolkitbot | Realiza análisis de contenido y monitoreo de medios. | 5 |

| 96 | megaindex | Realiza análisis SEO y scraping de contenido. | 6 |

| 97 | miner | Realiza minería de datos, puede ser intensivo en recursos. | 8 |

| 98 | mj12bot | Realiza análisis SEO y rastreo web. | 5 |

| 99 | moatbot | Utilizado para análisis de publicidad y contenido. | 6 |

| 100 | morfeus | Realiza actividades de scraping y posibles ataques. | 10 |

| Nº | User Agent | Descripción | Clasificación de Bloqueo |

|---|---|---|---|

| 101 | moveoverbot | Realiza scraping web y puede ser intensivo en recursos. | 7 |

| 102 | netmechanic | Realiza análisis de sitios web, puede ser intensivo. | 6 |

| 103 | netspider | Realiza scraping web y análisis de contenido. | 7 |

| 104 | nicerspro | Realiza scraping web y puede ser intensivo. | 7 |

| 105 | nikto | Herramienta de análisis de vulnerabilidades, potencialmente peligrosa. | 10 |

| 106 | nimbostratus | Realiza scraping web y análisis de contenido. | 7 |

| 107 | ninja | Realiza scraping y análisis de contenido web. | 7 |

| 108 | nominet | Realiza análisis de contenido y scraping. | 6 |

| 109 | nutch | Herramienta de rastreo web, puede ser intensiva en recursos. | 6 |

| 110 | octopus | Realiza scraping web, potencialmente malicioso. | 8 |

| 111 | okhttp | Biblioteca de cliente HTTP, utilizada en scripts de scraping. | 6 |

| 112 | pagegrabber | Realiza scraping web, puede ser intensivo en recursos. | 7 |

| 113 | petalbot | Utilizado por Petal Search para indexación y análisis de contenido. | 5 |

| 114 | planetwork | Realiza scraping web y análisis de contenido. | 7 |

| 115 | postrank | Realiza análisis de contenido y monitoreo de medios. | 5 |

| 116 | proximic | Realiza análisis de contenido web, generalmente con fines publicitarios. | 6 |

| 117 | purebot | Realiza scraping y análisis de contenido web. | 7 |

| 118 | pubmatic | Utilizado para análisis de publicidad, puede ser intensivo. | 6 |

| 119 | queryn | Realiza scraping web y análisis de contenido. | 7 |

| 120 | queryseeker | Realiza scraping web, puede ser intensivo en recursos. | 7 |

| 121 | radian6 | Utilizado para monitoreo de redes sociales y análisis de contenido. | 5 |

| 122 | radiation | Realiza scraping web y análisis de contenido. | 7 |

| 123 | rasabot | Realiza scraping web, conocido por ser intensivo. | 8 |

| 124 | realdownload | Gestor de descargas, puede generar múltiples solicitudes. | 6 |

| 125 | remoteview | Realiza scraping web y análisis de contenido. | 7 |

| 126 | riddler | Realiza scraping web, conocido por su actividad intensiva. | 9 |

| 127 | rogerbot | Realiza análisis SEO y rastreo web. | 5 |

| 128 | scan | Realiza escaneo de sitios web en busca de vulnerabilidades. | 9 |

| 129 | sbl-bot | Realiza scraping web, conocido por ser intensivo. | 7 |

| 130 | scooter | Realiza scraping web y análisis de contenido. | 7 |

| 131 | scrapy | Framework de scraping, utilizado para scraping masivo de contenido. | 9 |

| 132 | seekerspid | Realiza scraping web y análisis de contenido. | 7 |

| 133 | seekport | Utilizado por motores de búsqueda para rastreo web. | 5 |

| 134 | semantic-visions | Realiza análisis de contenido web, generalmente con fines de monitoreo. | 6 |

| 135 | semanticbot | Realiza scraping web y análisis de contenido. | 7 |

| 136 | semalt | Utilizado para análisis SEO y rastreo web. | 7 |

| 137 | semrush | Utilizado por Semrush para análisis SEO y backlinks. | 6 |

| 138 | serpstatbot | Utilizado para análisis SEO y rastreo web. | 5 |

| 139 | siclab | Realiza scraping web y análisis de contenido. | 7 |

| 140 | sindice | Realiza scraping web y análisis de contenido. | 7 |

| 141 | sistrix | Utilizado por Sistrix para análisis SEO y rastreo web. | 5 |

| 142 | siteauditbot | Realiza auditorías de sitios web, utilizado para análisis SEO. | 5 |

| 143 | sitebot | Realiza scraping y análisis de contenido web. | 7 |

| 144 | siteexplorer | Realiza análisis SEO y rastreo web. | 6 |

| 145 | sitesnagger | Realiza scraping web, puede ser intensivo en recursos. | 7 |

| 146 | skygrid | Realiza análisis de contenido web y monitoreo de medios. | 5 |

| 147 | smartdownload | Gestor de descargas, similar a flashget. | 6 |

| 148 | snoopy | Utilizado en scripts de scraping y análisis de contenido. | 6 |

| 149 | sosospider | Utilizado por Sogou, un motor de búsqueda chino. | 5 |

| 150 | spankbot | Realiza scraping web y análisis de contenido. | 7 |

| 151 | spbot | Realiza scraping web y análisis de contenido. | 7 |

| 152 | sqlmap | Herramienta utilizada para detectar vulnerabilidades SQL, frecuentemente con fines maliciosos. | 10 |

| 153 | stackrambler | Realiza scraping web y análisis de contenido. | 7 |

| 154 | stripper | Realiza scraping web, potencialmente malicioso. | 8 |

| 155 | sucker | Realiza scraping web y puede ser intensivo en recursos. | 7 |

| 156 | surftbot | Realiza scraping web y análisis de contenido. | 7 |

| 157 | sux0r | Realiza scraping web y análisis de contenido. | 7 |

| 158 | suzukacz | Realiza scraping web, puede ser intensivo. | 7 |

| 159 | suzuran | Realiza scraping web y análisis de contenido. | 7 |

| 160 | takeout | Realiza scraping web, potencialmente malicioso. | 8 |

| 161 | teleport | Herramienta de clonación de sitios web, puede generar muchas solicitudes. | 8 |

| 162 | telesoft | Realiza scraping y análisis de contenido web. | 7 |

| 163 | tineye | Utilizado para búsqueda inversa de imágenes. | 5 |

| 164 | trendictionbot | Utilizado para monitoreo de tendencias y análisis de contenido. | 5 |

| 165 | true_robots | Realiza scraping y análisis de contenido web. | 7 |

| 166 | turingos | Realiza scraping y análisis de contenido web. | 7 |

| 167 | turnit | Realiza scraping y análisis de contenido web. | 7 |

| 168 | vampire | Realiza scraping web, conocido por ser intensivo en recursos. | 8 |

| 169 | vikspider | Realiza scraping web, puede ser intensivo. | 7 |

| 170 | voideye | Realiza scraping web y análisis de contenido. | 7 |

| 171 | voluumdsp | Realiza análisis de publicidad digital, puede consumir recursos significativamente. | 8 |

| 172 | webleacher | Realiza scraping web, puede ser intensivo en recursos. | 7 |

| 173 | webreaper | Herramienta de scraping y clonación de sitios web. | 8 |

| 174 | webstripper | Realiza scraping web y puede ser intensivo. | 7 |

| 175 | webtechbot | Realiza análisis tecnológico de sitios web. | 6 |

| 176 | webvac | Realiza scraping web, puede ser intensivo en recursos. | 7 |

| 177 | webviewer | Realiza scraping web y análisis de contenido. | 7 |

| 178 | webwhacker | Herramienta de clonación de sitios web, puede generar muchas solicitudes. | 8 |

| Nº | User Agent | Descripción | Clasificación de Bloqueo |

|---|---|---|---|

| 179 | whatcms | Utilizado para identificar CMS utilizados en sitios web. | 6 |

| 180 | winhttp | Biblioteca HTTP de Windows, utilizada en scripts y herramientas de scraping. | 6 |

| 181 | wwwoffle | Herramienta de caching web, puede generar múltiples solicitudes. | 6 |

| 182 | woxbot | Realiza scraping web y análisis de contenido. | 7 |

| 183 | xaldon | Realiza scraping web, puede ser intensivo en recursos. | 7 |

| 184 | xxxyy | Realiza scraping web y análisis de contenido. | 7 |

| 185 | yamanalab | Realiza scraping web y análisis de contenido. | 7 |

| 186 | yioopbot | Utilizado en motores de búsqueda, realiza rastreo web. | 5 |

| 187 | youda | Realiza scraping web, puede ser intensivo. | 7 |

| 188 | zeus | Realiza scraping web y análisis de contenido. | 7 |

| 189 | zmeu | Realiza scraping web, potencialmente malicioso. | 8 |

| 190 | zoominfobot | Realiza scraping web y recopilación de datos para análisis. | 7 |

| 191 | zune | Biblioteca utilizada en herramientas de scraping y análisis. | 6 |

| 192 | zyborg | Realiza scraping web y análisis de contenido. | 7 |